Le dictionnaire de l’IA : LLMs, chatbot RAG, extrabot…

LLM, chatbot RAG, extrabots… Si le jargon de l’IA vous donne le tournis, pas de panique ! On vous éclaire avec les définitions essentielles et les usages incontournables à connaître.

LLM, Chatbot RAG, Extrabot… L’IA, vous connaissez mais les termes qui gravitent autour, beaucoup moins ? Découvrez leurs définitions et l’essentiel à retenir dans notre dictionnaire de l’IA !

L’un de vos collègues vous a parlé des dernières avancées en matière de LLM, de la nécessité d’avoir un chatbot RAG ou de sa volonté de déployer les extrabots Jamespot… et vous avez décroché après les premières secondes de conversation ?

On vous partage les mots et définitions à connaître pour mieux comprendre l’IA ainsi que les fonctionnalités Jamespot qui reposent sur cette technologie.

C’est parti !

C’est quoi un LLM ?

Un LLM (Large Language Model) est un modèle d’intelligence artificielle capable de comprendre et de produire du texte humain grâce à l’apprentissage de grandes quantités de données. Ce n’est pas exactement un logiciel comme un traitement de texte, mais plutôt une technologie centrale, semblable à un moteur.

Par exemple :

- Le LLM (le moteur) : GPT-4 (OpenAI), Mistral 7B (Mistral AI)

- Le Chat ( la voiture complète) : ChatGPT, Chat Mistral

Métaphore : Un LLM est comme le moteur d’une voiture. ChatGPT, lui, est la voiture dans son ensemble: confortable, avec une interface pensée pour être facilement utilisable par les utilisateurs.

Comment un LLM est-il fabriqué ?

- Collecte : On rassemble énormément de textes (internet, livres, Wikipédia, github) ;

- Nettoyage : On retire les doublons, les erreurs et les données sensibles (comme trier les fruits pour ne garder que les bons) ;

- Filtrage : On sélectionne uniquement les données pertinentes (garder les fruits adaptés à notre recette) ;

- Normalisation : On harmonise le texte (mettre tous les fruits dans la même taille et forme) ;

- Tokenisation : On découpe les textes en petits morceaux compréhensibles pour le modèle ;

- Structuration : On répartit les données en plusieurs ensembles pour entraîner et tester le modèle.

Ce qu’un LLM fait… ou ne fait pas ?

✅ Ce qu’il fait seul :

Générer, traduire, résumer, répondre à des questions.

🚫 Ce qu’il ne peut pas faire seul :

Chercher sur internet en temps réel ou accéder à des informations très récentes.

LLM et ChatGPT : quelles différences et similarités ?

LLM : Un LLM est une technologie de base qui sert de moteur aux modèles d’IA générative.

ChatGPT : ChatGPT n’est pas une technologie mais une application complète avec une interface et des fonctionnalités supplémentaires (la voiture complète prête à rouler.)

- Par exemple, GPT-4 est le moteur (le LLM), tandis que ChatGPT est la voiture (l’application)construite autour de ce moteur, prête à être utilisée facilement par les utilisateurs.

- ce qu’il fait: répondre en utilisant un LLM, aller chercher en « live » sur internet, garder une mémoire des échanges avec l’utilisateur pour s’adapter (contexte étendu), fournir des réponses au-delà du texte (mise en forme, documents, etc…)

C’est quoi un RAG ?

Un modèle RAG (pour Retrieval Augmented Generation ou en bon français Génération Augmentée de Récupération) combine deux capacités : rechercher des informations dans une base de données existante et générer du contenu en se basant sur ces mêmes informations.

Les modèles de langage standards (LLM) comme GPT-4 n’ont pas accès à des informations récentes ou spécifiques contrairement aux modèles RAG qui permettent :

- D’obtenir des réponses précises et à jour ;

- De réduire les erreurs (« hallucinations ») ;

- De fournir des références exactes aux documents utilisés.

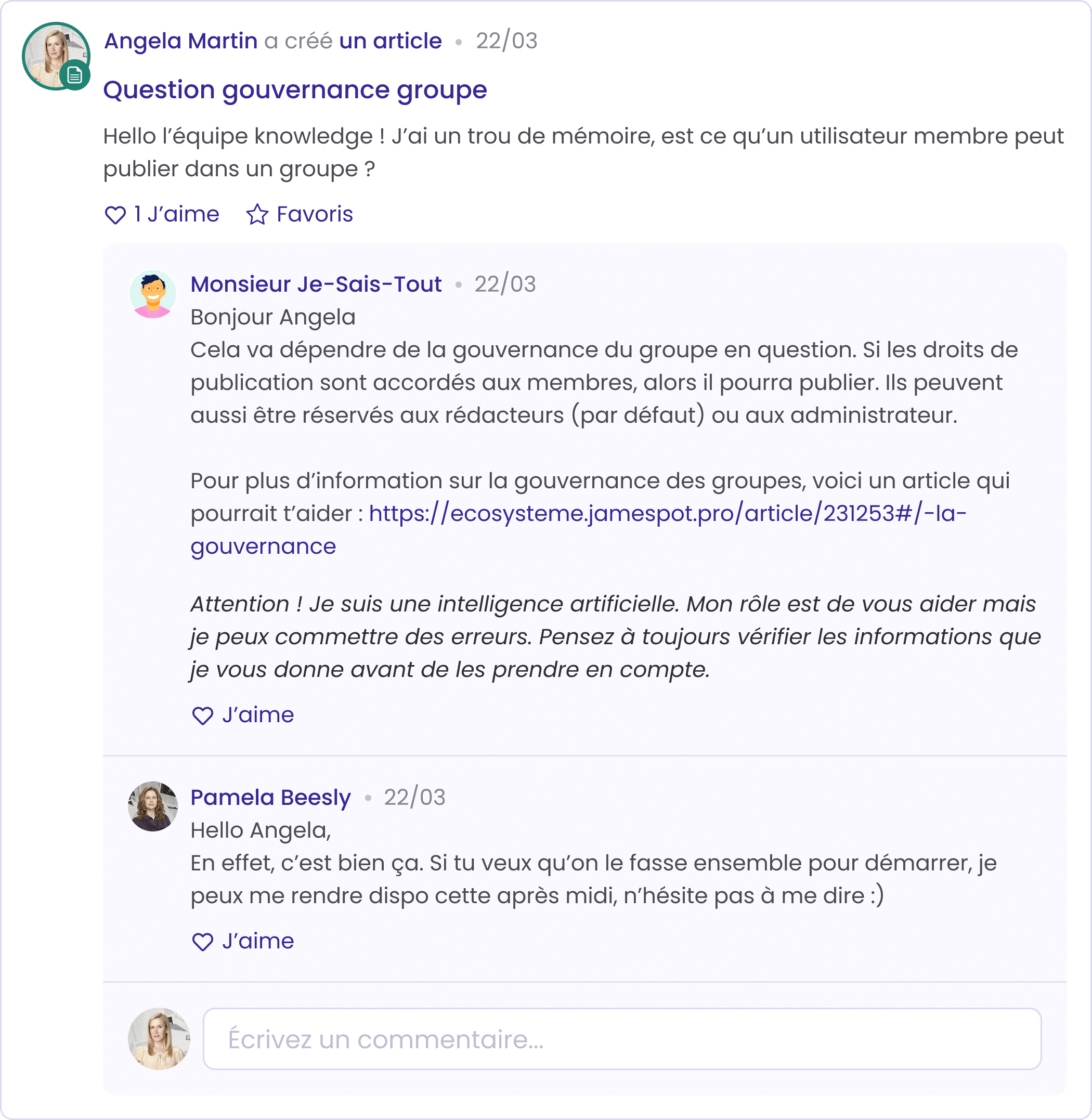

Un chatbot construit sur un modèle RAG va donc se baser, non pas sur de très gros volumes de données comme le font la plupart des chatbots, mais sur une base de données précise, ce qui va réduire sa marge d’erreur et fournir des réponses plus précises aux questions posées.

Il démontre ainsi toute son utilité par exemple dans le cadre d’une utilisation interne, pour partager des informations aux collaborateurs autour de la politique de l’organisation.

Comment fonctionne un RAG ?

- Recherche (Retrieval) : Le système récupère des informations pertinentes dans une base documentaire externe.

- Génération (Generation) : Le LLM utilise ces informations pour générer une réponse précise et vérifiée.

Exemple : une question technique déclenche une recherche automatique dans une documentation, puis le LLM répond précisément à partir des résultats obtenus.

Et les fonctionnalités Jamespot dans tout ça ?

Maintenant que vous êtes incollables sur les définitions, regardons quelles formes prennent ces différentes technologies dans la solution Jamespot. Il s’agit ici de vous donner les explications techniques : si vous souhaitez en apprendre plus sur les avantages que ces fonctionnalités offrent, ça se passe juste ici.

La baguette magique pour la rédaction de contenus

La baguette magique est une interface qui permet de faciliter l’utilisation d’un service qui expose ou fait tourner le LLM, (désolé, on est à court de métaphore mécanique…).

Les Extrabots : vos agents virtuels autonomes

Un extraBot est une interface de type « agent » (comme le membre d’une équipe) qui est capable de récupérer de la donnée directement dans la plateforme, pour ensuite aller exécuter des tâches complexes via de l’automatisation de workflow (n8n) et qui PEUT interroger un LLM si nécessaire.

En termes d’usages, un extrabot se voir confier une mission bien précise et la réalisera automatiquement selon le contexte. Par exemple : analyser la fiche prospect rempli par un commercial et lui partager des conseils précis pour augmenter ses chances de conclure le deal.

Mr-Smith.AI

Mr-smith est une interface qui permet de gérer un service de type RAG « Retrieval-Augmented Generation »:

✅ Ce qu’il Fait

- On lui donne des documents, et il ajoute le contenu des documents aux question des utilisateurs, ces documents s’ajoute au contexte ;

- Ce contexte consolidé par les documents spécifiques est envoyé à un LLM, qui va alors répondre en utilisant tout ce qu’il sait déjà grâce à son apprentissage de base PLUS les informations qu’on lui a donné en plus dans le contexte ;

- Ajoute le contenu des sites ajouté dans l’admin.

🚫 Ce qu’il ne fait pas

- Aller chercher des infos sur internet pour mettre à jour ses connaissances ;

- Ne retient pas les informations au fur et à mesure des utilisations (pas d’auto-apprentissage).

Et voilà, fini les moments de gêne : vous avez à présent toutes les clés en main pour briller dans vos futures conversations autour de l’IA !

On espère que ce petit dictionnaire vous aura plu : n’hésitez pas à le partager aux collègues qui ont eux-aussi besoin d’une remise à niveau !